00174 NLP Course - Introduction ubuntu

前言

本课程将使用来自Hugging Face生态系统的库——🤗Transformers、🤗Datasets、🤗Tokenizers和🤗Accelerate——以及Hugging Face Hub——教你自然语言处理(NLP)。它完全免费,没有广告。

src link: https://huggingface.co/learn/nlp-course/chapter1/1

Operating System: Ubuntu 22.04.4 LTS

参考文档

预期会发生什么

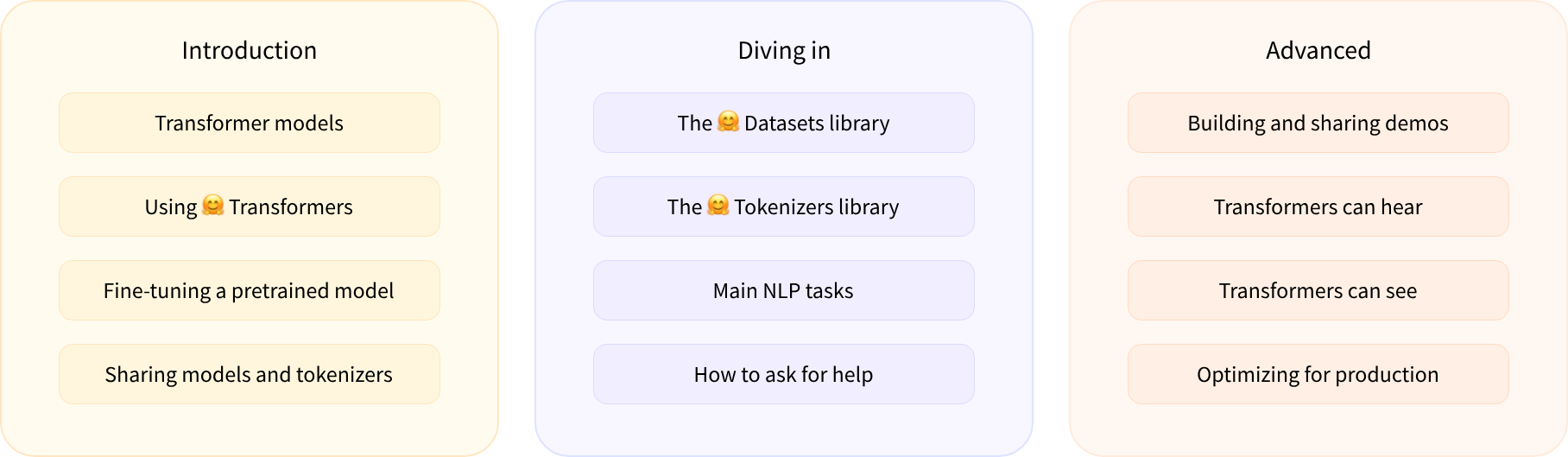

以下是课程的简要概述:

第1章到第4章介绍了🤗Transformers库的主要概念。在课程的这一部分结束时,您将熟悉Transformer模型的工作原理,并了解如何使用Hugging Face Hub中的模型,在数据集上微调它,并在Hub上分享您的结果!

第5章到第8章在深入研究经典的NLP任务之前,教授🤗Datasets和🤗Tokenizers的基础知识。在这一部分结束时,您将能够自己解决最常见的NLP问题。

第9章到第12章超越了NLP,探索了如何使用Transformer模型来处理语音处理和计算机视觉中的任务。在此过程中,您将学习如何构建和共享模型演示,并针对生产环境对其进行优化。在本部分结束时,您将准备好将🤗Transformers应用于(几乎)任何机器学习问题!

本课程:

- 需要良好的Python知识

- 最好在介绍性深度学习课程之后进行,例如fast.ai的程序员实用深度学习或DeepLearning.AI开发的程序之一

- 不期望先前的PyTorch或TensorFlow知识,尽管熟悉其中任何一个都会有所帮助

完成本课程后,我们建议您查看DeepLearning.AI的自然语言处理专业化,它涵盖了广泛的传统NLP模型,如朴素贝叶斯和LSTM,非常值得了解!

包含课程所有代码的Jupyter笔记本托管在huggingface/notebooks存储库中。如果您希望在本地生成它们,请查看GitHub上课程存储库中的说明。

Let’s Go

你准备好了吗?在本章中,您将学习:

- 如何使用pipeline()函数解决文本生成和分类等NLP任务

- 关于Transformer架构

- 如何区分编码器、解码器和编码器-解码器架构和用例

结语

第一百七十四篇博文写完,开心!!!!

今天,也是充满希望的一天。